Desciframos paso a paso la Inteligencia Artificial

Ya casi todo el mundo hemos oído hablar del chatbot ChatGPT (e incluso hemos “conversado” con “él”), una herramienta que responde a todo lo que le pedimos por escrito: redacta cualquier tipo de texto, resume o desarrolla cualquier idea o argumento, incluso es capaz de programar.

Y todo ello lo hace de forma casi indistinguible de cómo lo haría un ser humano.

Quizás también os suene el nombre de los software DALL·E 2 o Midjourney, dos IA que, con indicaciones por escrito, crean imágenes, fotografías y dibujos muy verosímiles.

Y hay muchas más, especializadas en otros temas, como el diseño, la música o la educación.

Estas herramientas son lo que se denomina Inteligencia Artificial Generativa, porque tienen la capacidad de generar contenidos nuevos.

La IA generativa tiene grandes aplicaciones, todas ellas con un enorme potencial para la especie humana.

Puestos a soñar, quizás llegue el día en que este tipo de IA nos permita dejar de trabajar y dedicarnos a lo que más nos gusta.

¿Es muy utópico pensar que estamos más cerca que nunca de la verdadera sociedad del bienestar?

Cierto, un pequeño reducto de pensadores y tecnólogos está generando un alarmismo injustificado. Dicen que la IA esconde ciertos peligros. Que no es inocua.

Seguramente estos “expertos” serían los mismos que en la época de la Revolución Industrial advertían sobre los peligros de los telares mecánicos. Y es que reconozcámoslo, no tiene sentido ponerle puertas al campo.

Si crees que todo lo que acabas de leer es cierto, enhorabuena, has asimilado el relato imperante sobre la IA.

Quizás te iría bien seguir leyendo este artículo…

El relato mediático: cómo se habla de la IA

El impacto en nuestra percepción de la tecnología “inteligente” está influido por cómo recibimos la información al respecto. Y la forma en que se construye este relato informativo, no está exento de los intereses comerciales de las grandes empresas que producen y distribuyen esta tecnología.

En el estudio de Mediacat ¿Cómo se informa sobre inteligencia artificial? (de ámbito catalán), Bru Aguiló y Paul Zalduendo concluyen que en los medios se habla de ésta de forma transversal, y no sólo en las secciones de tecnología. El informe señala que, sobre todo, se hacen noticias sobre la industria de la IA, y no con un enfoque de derechos humanos.

Además, las fuentes de estas noticias son a menudo las propias empresas que la fabrican y comercializan, y rara vez se pone el foco en los riesgos o en la falta de regulación, sino que se hace hincapié en sus beneficios.

Tengamos presente, pues, que el impacto y el ruido mediático no se adecuan a la realidad.

Por un lado, porque no es algo tan nuevo: la inteligencia artificial ya estaba en nuestras vidas mucho antes de todo ese alboroto.

Y, por otro lado, si bien la inteligencia artificial mejora la eficiencia y la productividad en tareas complejas y repetitivas, o puede incluso mejorar la precisión y la celeridad de diagnósticos médicos, también abre múltiples controversias y debates.

No hay que olvidar, además, que la IA no es neutral.

Nos la venden como tal con el argumento de que aquello basado en la ciencia (números, fórmulas, …) es más objetivo y eficaz. Pero esto puede ser perverso: en “nombre” de los números, pueden dejarse de lado criterios éticos o de derechos fundamentales.

Al fin y al cabo, señala Vicent Costa, la financiación de la investigación en IA es privada, y las principales creadoras y comercializadoras son Microsoft (empresa de la que forma parte OpenAI, desarrolladora del ChatGTP entre otros), Google, Facebook y Amazon.

Estas empresas también nos hablan de la complejidad de estas herramientas. Utilizan terminología complicada, hablan de grandes volúmenes de datos. Como si el conocimiento de la IA estuviera encerrado en “cajas negras”…

Y claro, lo que es muy complicado mejor dejarlo a los expertos. No vale la pena tratar de comprenderlo.

Pues, de nuevo, resulta que no es tan difícil de comprender, y que, entendiendo las bases de ésta tecnología podemos entender mucho mejor los riesgos y potencialidades. Vamos por partes.

¿Qué es la IA?

En primer lugar, profundicemos un poco: ¿de qué hablamos cuando hablamos de Inteligencia Artificial?

En el informe ¿Cómo se informa sobre inteligencia artificial?, se hace un breve repaso de su definición.

La definición actual (no libre de controversia, como veremos más adelante) “se aplica a cualquier máquina que imita las funciones cognitivas, como percibir, razonar, aprender o resolver problemas”.

Sin embargo, la palabra fue acuñada en 1956 por John McCarthy, como “la ciencia de hacer máquinas inteligentes”.

Más tarde, en 2004, él mismo hizo evolucionar la definición, añadiendo que la IA «está relacionada con la tarea de utilizar ordenadores para comprender la inteligencia humana».

Es tecnología que funciona por algoritmos, o lo que es lo mismo, conjuntos de operaciones e instrucciones, previamente definidas, destinadas a ejecutar tareas concretas: realizar cálculos , resolver problemas o tomar decisiones.

Como una receta de cocina, el algoritmo es lo que le sirve a la IA para ejecutar las acciones. Pero así como la receta no puede hacerse sola, el algoritmo no es una acción sino el conjunto de pasos para llevarla a cabo. Así, la IA es tecnología a la que se incorpora la receta (el algoritmo) para que la siga de forma automática y repetida cada vez que introduzcamos unos “ingredientes”.

A medida que ha ido avanzando la investigación y práctica en torno a la IA, se ha ido complejizando la combinación y creación de estos conjuntos algorítmicos. Llegando a la actualidad a lo que se llaman «redes neuronales profundas», que imitan el funcionamiento de nuestro cerebro.

Estas redes artificiales funcionan de distintas formas. Las podemos clasificar por tipos:

- La IA generativa: «crea» contenidos (imágenes, textos, …) a partir de información que se le ha introducido previamente.

- La IA predictiva: frente a un estímulo externo, esta tecnología puede producir una respuesta sin haber almacenado datos o experiencias previas. Un ejemplo serían los asistentes de voz de Apple o Google Siri y Alexa.

- La IA con teoría de la mente: a pesar de no tenerla, sabe cómo funcionan las intenciones o deseos humanos, y podría interactuar con ella. Por ejemplo, cambiar el comportamiento según las circunstancias que interpretaría en el interlocutor/a.

- La IA autorreflexiva: una inteligencia que realmente piense por sí misma es el tipo que de momento sólo es una especulación… y la que puede parecer más peligrosa.

Y para que sean capaces de todo esto, se entrenan: para hacerlas más precisas e “inteligentes”, se las alimenta de grandes volúmenes de datos, relacionando conceptos y definiciones, causa y efecto, etc.

A medida que tienen más y más información, que a priori (en el momento de introducción de datos) no está conectada entre sí, estas redes pueden llegar a extraer conclusiones y respuestas complejas.

La IA la encontramos en muchas de las aplicaciones tecnológicas que utilizamos todos los días. En diagnósticos e intervenciones médicas, en los cajeros automáticos, en los GPS, en las redes sociales, en la publicidad personalizada,… también a la hora de pedir un préstamo o una hipoteca a entidades bancarias, o en solicitudes de ayudas económicas, como becas o prestaciones sociales.

¿Pero es inteligencia? ¿Y es artificial?

“En realidad, lo que hoy llamamos Inteligencia Artificial no es artificial ni inteligente”. Así de tajante se muestra el autor de este artículo, publicado originalmente en The Guardian, el periodista, informático y filósofo Evgeny Morozov. Argumenta que los primeros sistemas de IA estaban regidos por programas, y entonces estaba justificado, como mínimo, «hablar de artificialidad».

Pero que en la actualidad:

- No es artificial porque detrás hay fuerza de trabajo humana: ya sea la de los «artistas, músicos, programadores y escritores cuya obra es expropiada» para nutrir las bases de datos de estas interfaces, como por todas aquellas trabajadoras que introducen datos. Trabajo, este último,“muy precario, con una gran presencia de mujeres que entrenan estos algoritmos y moderan sus contenidos”, como afirma en esta interesante entrevista Alex Haché, activista ciberfeminista integrante de Donestech.

- No es inteligencia porque ser inteligente no es sólo ser capaz de identificar o reproducir patrones que coinciden, sino otras muchas cosas que escapan a la racionalidad. Por ejemplo, generalizar (agrupar ideas, conceptos, objetos, recuerdos) a partir de las emociones. Ninguna máquina, dice Morozov, tiene sentido (más allá del hecho de conocerlo) “del pasado, del presente y del futuro, de la historia, de lo que duele, de la nostalgia”. Lugares de los que parten las emociones. Y si no hay emoción, no existe inteligencia: es simple lógica formal.

Por eso hay quien prefiere llamarla «sistemas de decisiones automatizadas». Entre ellos, Evgeny Morozov, que explica que si utilizamos el término «inteligencia artificial» podemos llegar a creer que «el mundo funciona bajo esta lógica formal», racional y fría.

El filósofo Ariel Guersenzvaig, en la charla de presentación el informe de Mediacat antes mencionado, dice que a menudo, bajo ésta mirada deshumanitzadora «se olvidan las condiciones de los trabajadores detrás de estos sistemas: programadores, quienes pican datos o quienes los mantienen».

El también filósofo y matemático Vicent Costa (recomendamos leer la entrevista que Gemma Garcia le hace a la Directa número 567), especifica que la IA “puede simular” aspectos que consideramos humanos como la conciencia, la empatía, pero todo es aprendido, no oído. “Nunca tendrá”, capacidades genuinamente humanas.

Aunque los modelos de inteligencia artificial no siguen procesos cognitivos como los nuestros, muchas veces, les atribuimos estas capacidades. Seguramente, muy influidas por la ciencia ficción, que nos lleva a mundos donde los robots tienen incluso alma y deseos profundos. Y esto nos da miedo: ¿seremos sustituidas? O peor: ¿conquistadas y exterminadas?

Por eso es importante la forma en que se habla de la IA: “se explica la IA como una caja negra en la que no sabemos qué pasa” afirma Ariel Guersenzvaig, lo que da lugar a muchas interpretaciones de cómo funciona y hasta dónde puede llegar este tipo de tecnología, así como puede “diluir las responsabilidades” de los impactos que puede llegar a tener.

Derechos y democracia: los riesgos de la IA

La IA puede utilizarse para manipular nuestras percepciones de la realidad, y modificar nuestras opiniones… Y esto puede ser fatal para la democracia.

Vamos a lo peor: un movimiento político sin escrúpulos podría utilizar la IA, por un lado, para encontrar a las personas sensibles a cierto tipo de mensajes, y por el otro, generando deepfakes: imágenes y vídeos falsos que parecen reales, que dieran verosimilitud a estos mensajes.

Este tipo de riesgos son los que se explican en este interesante cortometraje documental que imagina la evolución de la IA y sus efectos en la sociedad en los próximos 10 años.

Otros usos cuestionables de este tipo de tecnología son el militar y la vigilancia. Son ejemplos las armas que no necesitan humanos que las disparen, o el control en muchas ciudades mediante cámaras de reconocimiento facial.

Este último tema, aunque no seamos conscientes de ello, nos toca de cerca, porque las ciudades (en las calles, en las tiendas, …) están cada vez más llenas de cámaras de vigilancia.

Realmente es muy fácil obtener información sobre nosotros sin que hayamos dado permiso. Como Maria Vanrell menciona,«vamos regalando información por la calle»: las cámaras de vigilancia saben cómo vestimos, por dónde nos movemos, la forma y rasgos identificativos de nuestro cuerpo, con quien nos relacionamos.

Estos dispositivos pueden llegar a ser una herramienta brutal de control social, porque pueden reconocer nuestros rasgos y atribuirlos a nuestra identidad.

En China, por ejemplo, han ideado un sistema de disciplinamiento en base a las conductas observables y adjudicables a cada ciudadano/a a través de las cámaras.

Pero aquí no nos escapemos: con la excusa de la “seguridad”, tenemos cada vez más ojos puestos en nuestros movimientos, dispuestos a registrar cada paso, a hacernos sentir que nosotros o alguien cerca de nosotros puede cometer un acto de incivismo, o incluso un delito en cualquier momento.

¿No os parece una manera de meternos el miedo dentro? ¿De hacernos sentir aún más inseguras? ¿No os suena un poco a “El gran hermano” del que hablaba Orwell en 1984?

Pero no sólo están las cámaras para controlarnos. Es que además, los bancos saben qué, dónde y cuándo compramos, las apps de geolocalización saben por dónde nos movemos, las redes sociales se saben de memoria nuestros gustos y nuestra debilidades.

Capitalismo de datos… o cómo exprimirnos al máximo

Basta pensar en cómo actúan los algoritmos: de repente, en el feed de Instagram, o en los resultados de Google comienzan a aparecer anuncios de un mismo tipo de producto, o imágenes de gente haciendo actividades muy específicas…

Mensajes recurrentes que pueden llegar a hacernos creer que realmente tener arrugas es un problema y necesitamos esa crema, o que queremos realizar un taller de cerámica carísimo.

Es decir, que modifican nuestros intereses, o llegan a crearnos deseos que antes no teníamos.

Las solicitudes de hipotecas o ayudas sociales también están operadas por tecnología basada en inteligencia artificial, con todas las implicaciones en cuanto a derechos que puede tener que este tipo de decisiones sean automatizadas y no respondan a criterios éticos.

También se está aplicando la IA en sectores como los recursos humanos, y está determinando las condiciones laborales de muchas trabajadoras (por ejemplo utilizan IA en plataformas de reparto de comida a domicilio), a la vez que crea nuevos puestos de trabajo precarios enfocados a entrenar y alimentar a los algoritmos.

Otro riesgo es la utilización de IA en los procesos de contratación, lo que puede desembocar en la selección de aquellos perfiles «menos molestos» o que no generen pérdidas para el empresario.

¿Os imagináis una IA que, cruzando ciertos parámetros (actividad en redes, lenguaje no verbal…), pueda detectar que una persona quiere sindicarse o que tiene muchas probabilidades de tener hijos dentro de poco y descartarla por estos motivos?

Otro riesgo añadido es cómo la IA entra en el ámbito educativo. Nos reservamos este tema para explicároslo más adelante… ¡porque merece un artículo entero!

Algoritmos que reproducen sesgos racistas, machistas y clasistas

Los sesgos son comportamientos o prácticas discriminatorios que tenemos integrados “por defecto”, y que manifestamos cotidianamente a la hora de relacionarnos: con chistes, bromas, lugares a los que vamos y lugares por donde no queremos pasar, prejuicios, …

Y es que en las sociedades occidentales quizás nos creemos muy «progres», pero todavía estamos llenas de sesgos, fruto de los aprendizajes adquiridos a lo largo de nuestra vida. Éstos son muy difíciles de identificar, de saber de dónde lo hemos aprendido exactamente, e incluso de erradicar, por mucho que nos esforcemos.

Por analogía, cuando hablamos de sesgos en la IA, nos referimos a discriminaciones que están integradas en los mismos sistemas, porque los han aprendido, fruto del entrenamiento que han recibido.

Como mencionábamos antes, los algoritmos han cambiado: ya no funcionan como antes, cuando los sesgos eran identificables porque se introducían a la hora de crearlos o mejorarlos. Ahora se utilizan las redes neuronales profundas (deep learning): herramientas que se entrenan a base de múltiples bases de datos, y es muy difícil identificar los sesgos en ellas…

¿Por qué? Porque funcionan como el cerebro, de hecho están basadas en su funcionamiento. Tienen capacidad de aprender si las entrenamos. Y aprenden de la información que introducimos, y por tanto aprenden de datos (y personas) que sí tienen sesgo. Como nosotros, vaya.

Recomendamos leer esta entrevista en la politóloga Virginia Eubanks, que ha investigado cómo la IA, sumada a todos los mecanismos burocráticos de los servicios sociales o sanitarios puede perpetuar la pobreza, y de hecho, en EE.UU. es utilizada para controlar a las personas en situaciones de vulnerabilidad.

La organización Algorace, un colectivo multidisciplinar que trabaja para contribuir a enriquecer «el debate sobre el impacto del uso de la IA en las poblaciones racializadas», profundiza, en este informe, en el sesgo racista de los algoritmos, poniendo ejemplos de discriminaciones, y proponiendo estrategias para hacerles frente.

Y en la misma línea de estudiar los sesgos, en este caso, de género, la colectiva Donestech ha compartido algunos artículos que nos muestran cómo ni los avances más contemporáneos, como lo es la IA, escapan a la discriminación con motivo de género.

¿La IA, contamina?

Una de las consecuencias de la IA que puede pasar más desapercibida para el usuario final, es su elevado coste medioambiental. «Entrenar» un ordenador puede llegar a emitir 284 toneladas de dióxido de carbono equivalente(CO2e), que es lo que contaminan 47 personas en un año, o 5 vehículos a lo largo de toda su vida útil (incluida su fabricación).

Además, los centros de datos de donde proviene toda la información, lo que conocemos como «la nube», consumen alrededor del 2% de la energía global.

Pero el impacto comienza mucho antes. La extracción de materiales para fabricar estos sistemas, como el litio o el coltán, degrada el suelo, consume y contamina muchísima agua, contribuye al cambio climático… y todo eso a expensas de la explotación laboral de quien trabaja en la mina, muy a menudo, niños. Lo explicábamos en este artículo de nuestro blog.

Resumen: la IA, una tecnología peligrosamente útil

Volviendo a lo que comentábamos al principio: SÍ, la IA puede ser muy útil, y NO, no es una tecnología inocua.

Además, la Inteligencia Artificial (como otros muchos ámbitos de desarrollo tecnológico) avanza más rápido del tiempo que se necesita para medir sus consecuencias. Porque estas consecuencias se manifiestan en el ámbito social, escapando a toda previsión “tecnopositivista” (la mirada que se enfoca en lo positivo de los avances tecnológicos, en las soluciones que nos aporta a nivel productivo o económico).

¿Cómo podemos detectar los riesgos? ¿Y qué podemos hacer para evitarlos? Lo cierto es que a nivel individual podemos hacer poco, más allá de utilizar estas herramientas con conciencia.

Donde es necesario actuar es en el ámbito comunitario e institucional.

Por eso, surgen diversas instituciones públicas y privadas, u organizaciones que exigen regulaciones que garanticen que la investigación y el uso de las aplicaciones con IA no ponga en riesgo los derechos fundamentales, no fomente las desigualdades, o no genere impactos negativos en las vidas humanas y no humanas (ya sea en lo material como en lo inmaterial: de socialización, psicológico o emocional).

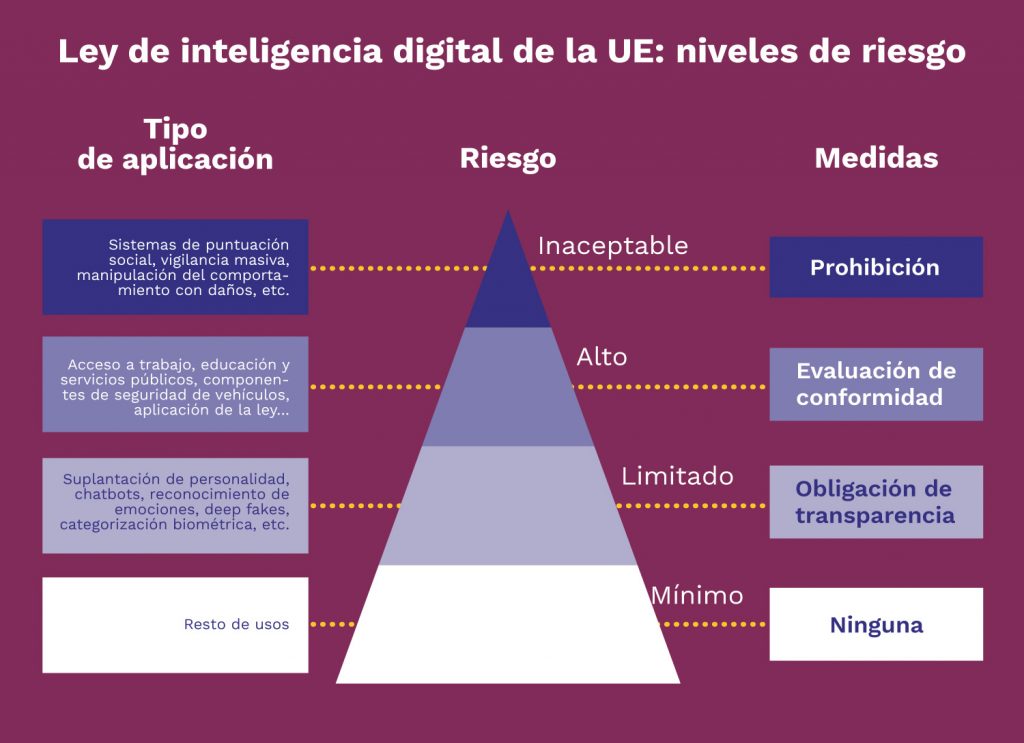

En 2021 se aprobaba la normativa de la Unión Europea. Y no es la única. En todo el mundo se han establecido marcos reguladores para prevenir los riesgos y actuar sobre este fenómeno que es la IA. El objetivo de esta ley es, según el mismo texto, garantizar «la seguridad de los usuarios» aunque esto vaya en detrimento de las empresas que parecen tener prisa por aplicarla.

Si os interesa, en este enlace encontraréis el análisis que hace Marta Galceran, investigadora del CIDOB (Centro de Información y Documentación Internacional en Barcelona), y cómo la compara con diferentes regulaciones de la IA, que se han ido constituyendo desde 2016 en diversos contextos territoriales.

Vicent Costa opina que es necesaria una moratoria para la aplicación de ciertas tecnologías, y que por ejemplo, antes de la salida al mercado de ciertos productos basados en la IA, deberían probarse y medir su posible impacto. Como un medicamento, o una nueva vacuna…

Y es que la IA puede tener soluciones para algunos aspectos de nuestras vidas, pero quizás es necesario revisar que realmente nos es útil introducirla indiscriminadamente en todo lo que hacemos.

Como siempre, en Som Connexió hemos propuesto una mirada crítica.